daily.jstor

19 دسامبر 2022

سرآغاز تاریخ

ویلیام مکاسکیل

ما در ابتدای تاریخ نوع بشر ایستادهایم. بهازای هرکسی که امروز زنده است، ده نفر در گذشته زندگی کرده و درگذشتهاند. اما اگر گونهی انسان بهاندازهی میانگین دیگر گونههای پستاندار باقی بماند، بهازای هر نفری که امروز زندگی میکند، هزار نفر در آینده زندگی خواهند کرد. ما مردمان باستان هستیم. در مقایسه با زندگیِ یک شخص معمولی، بشریت امروز از نوزادی که نخستین گامهای خود را برمیدارد، بزرگتر نیست.

گرچه آیندهی گونهی ما هنوز ممکن است طولانی باشد اما این امکان نیز هست که زودهنگام پایان یابد. از زمان انتشار نخستین شمارهی این نشریه در یک قرن پیش، تحولات بسیاری رخ داده است و از میان آنها عمیقترینشان تواناییِ بشر برای پایاندادن به حیات خود است. از تغییرات اقلیمی تا جنگ اتمی، از بیماریهای همهگیرِ مهندسیشده تا هوش مصنوعیِ کنترلناپذیر و دیگر فناوریهای ویرانکننده که هنوز نمیتوانیم پیشبینی کنیم، تعداد خطراتی که بالقوه میتوانند پایان نوع بشر را رقم بزنند، نگرانکننده است.

بیش از سی سال قبل، در اواخر جنگ سرد، بعضی اندیشمندان آیندهی پیش رو را بسیار پابرجاتر تصور میکردند. ترس از خطر آخرالزمان که در تخیل دوران جنگ سرد بسیار زنده بود، رو به افول بود. پایان کمونیسم چند دهه بعد از شکست فاشیسم در دوران جنگ جهانی دوم، ظاهراً به اصلیترین مناقشات ایدئولوژیک خاتمه داده بود. سرمایهداری و دموکراسی بدون مانع رو به گسترش بودند. فرانسیس فوکویاما، نظریهپرداز سیاسی، جوامع دنیا را به دو بخش «پساتاریخی» و «تاریخی» تقسیم میکرد. برای نمونه، به باور او، جنگ ممکن بود همچنان در بخشیهای معینی از جهان بهشکل منازعات قومیتی یا فرقهای ادامه پیدا کند. اما جنگهای گسترده به تاریخ پیوسته بودند زیرا تعداد کشورهایی که در سوی دیگر تاریخ قرار داشتند، پیوسته در حال افزایش بود. آینده گسترهی کوچکی از انتخابهای سیاسی را در بر داشت و صلح نسبی، رفاه و آزادیهای فزایندهی فردی را نوید میداد.

چشمانداز آیندهای ابدی حالا جای خود را به چشمانداز فقدان آینده داده است. ایدئولوژیها هنوز گسلهای مهمی در ژئوپلیتیک هستند، جهانیشدن بازارها تفرقهافکن از آب درآمده و جنگ میان ابرقدرتها بهطور فزاینده محتمل به نظر میرسد. اما تهدیدهایی که متوجه آینده هستند، از اینها بزرگترند و امکان نابودی کل گونهی بشری را به همراه دارند. در مواجهه با خطر بالقوهی نابودی، احتمالاً در سالهای آینده گسترهی مباحثات بر سر سیاست و سیاستگذاری وسیعتر از دهههای گذشته خواهد بود. مجادلات بزرگ ایدئولوژیک بههیچوجه حل نشدهاند. در واقع احتمال دارد که با پرسشهایی بزرگتر هم مواجه شویم و مجبور شویم که طرحهای پیشنهادیِ رادیکالتری را در نظر بگیریم که با چالشهای ناشی از تحولات و مخاطرات آینده متناسباند. افقهای ما باید رو به گشودگی باشد نه بستگی.

یکی از مهمترین این چالشها آن است که نوع بشر چگونه خطرات هوشمندی خود را تحت نظارت خواهد آورد. پیشرفت در تولید سلاح، زیستشناسی و علوم رایانهای میتواند به پایان گونهی ما بینجامد، چه از طریق سوءاستفادهی عامدانه و چه از طریق تصادفات عمده. جوامع با خطراتی مواجهند که ابعادشان بهخودیخود میتواند هر اقدام هماهنگی را فلج کند. اما امروز دولتها میتوانند و باید گامهایی بامعنا بردارند تا اطمینان یابند که گونهی بشر بقا خواهد یافت، بیآنکه مزایای پیشرفت فناوری را کنار بگذارند. در واقع، جهان هماینک نیز برای غلبه بر چند خطر سهمگین نیازمند نوآوری است: بشر باید بتواند انرژی پاک تولید و ذخیره کند؛ بیماریهای تازه را وقتی هنوز قابل کنترل هستند، تشخیص دهد؛ و صلح میان ابرقدرتها را حفظ کند، بیآنکه این کار صرفاً بر توازن شکنندهی ناشی از تهدیدهای متقابل اتمی متکی باشد.

وضعیت کنونی فناوری و نهادهای مرتبط بههیچوجه امنیتبخش نیست بلکه برعکس خطرناک و شکننده است و جوامع باید راه گریزی از آن بیابند. برای ایجاد این راه گریز دولتها باید از خطراتی که با آن مواجهند آگاهتر باشند و سازوکارهای نهادین مستحکمی برای مدیریت آنها ایجاد کنند. این از جمله بهمعنای آمادگی برای بدترین شرایط ممکن در حیطههای مرتبطِ سیاستگذاری و پذیرش ایدهی «تنظیم سرعت نسبی پیشرفت فناوریها» است، به این معنا که پیشرفت فناوریهایی را که میتوانند پیامدهای بالقوهی خطرناکی داشته باشند، کاهش دهند (مانند تحقیقات زیستشناختی که میتواند به سلاح تبدیل شود) و درعینحال سرمایهگذاری و شتاب بیشتری به فناوریهایی بدهند که میتواند این خطرات را کاهش دهد، مانند نظارت بر آب پسماند برای تشخیص ارگانیسمهای بیماریزای جدید.

بزرگترین تغییر لازم، تغییر در زاویهی نگاه است. فوکویاما آینده را با اندکی اندوه مینگریست، آیندهای خاکستری و گسترهای بیماجرا؛ موقعیتی برای تکنوکراتها. او در سال ۱۹۸۹ چنین نوشت: «پایان تاریخ دورانی بسیار غمانگیز خواهد بود» که در آن «شجاعت، دلیری، تخیل و آرمانخواهی جای خود را به حسابگری اقتصادی، حل بیپایان مشکلات تکنیکی، دغدغههای زیستمحیطی و تأمین تقاضاهای پیچیدهی مصرفکنندگان خواهد داد». اما اینجا در ابتدای تاریخ، این چهارراه حساس در داستان زندگی بشر، نیازمند شجاعت و تخیل هستیم تا بتوانیم با چالشهای متنوع پیش رو مواجه شویم. برخلاف پیشبینی فوکویاما، افق سیاسی به خطی واحد تقلیل پیدا نکرده است. تحولات عظیم اقتصادی، اجتماعی و سیاسی هنوز امکانپذیر و لازماند. اگر خردمندانه عمل کنیم، قرن پیش رو با پذیرش دِین ما به آیندگان تعریف خواهد شد و نوههای نوههای ما با افتخار و سپاس به ما خواهند نگریست. اگر خرابکاری کنیم، شاید آنها هرگز چشم به جهان نگشایند.

آیندگان

سوابق ثبتشده در فسیلها نشان میدهد که گونههای پستاندار بهطور متوسط ۱میلیون سال زندگی میکنند. بر این مقیاس، تقریباً ۷۰۰هزار سال از زندگی گونهی ما باقی است. در طول این زمان، حتی اگر تنها یکدهم جمعیت کنونی زمین روی این کره زندگی کنند، تعداد کسانی که در آینده به دنیا خواهند آمد، به رقم شگفتانگیز ۱۰تریلیون نفر خواهد رسید.

علاوه بر این، گونهی ما تنها یکی از پستانداران معمولی نیست و کاملاً ممکن است که انسانها بسیار طولانیتر از همقطاران خود باقی بمانند. اگر تا زمانی که بسط خورشید زمین را بسوزاند دوام بیاوریم، نوع بشر صدهامیلیون سال دیگر ادامه خواهد یافت. فاصلهی زمانی ما با آخرین نوادگانمان بیشتر از فاصلهی ما با نخستین دایناسورها خواهد بود. و اگر روزی در فضا سکونت کنیم (چیزی که در فاصلهی هزاران سال دیگر کاملاً قابل تصور است) زندگی هوشمند زمینی میتواند تا زمان سوختن آخرین ستارهها در دههاتریلیون سال دیگر باقی بماند.

فکرکردن به درازای بالقوهی آیندهی بشر، ابداً نوعی بازی بیهوده با اعداد درکناپذیر نیست، بلکه برای فهم میزان سود و زیان احتمالیِ تصمیمهای ما ضروری است. کارهای امروز ما میتواند مشخص کند که آیا تریلیونها نوادهی ما زندگی خواهند کرد یا نه (و آیا با فقر یا بینیازی، جنگ یا صلح، بردگی یا آزادی مواجه خواهند بود)؛ امری که مسئولیت بیاندازهای را بر دوش ما میگذارد. پیامدهای عمیق چنین تغییری در زاویهی نگاه را میتوان در آزمایشهای چشمگیری مشاهده کرد که در یک شهر کوچک ژاپنی به نام یابابا به انجام رسیده است. قبل از گفتوگو دربارهی سیاستگذاریهای شهری، از نیمی از شرکتکنندگان خواسته شد که لباسهای نمایشی بپوشند و تصور کنند که مردم آینده و نمایندگان منافع نوههای شهروندان کنونی هستند. پژوهشگران نهتنها «تضادی آشکار در شیوههای مشورت و اولویتها میان گروههای مختلف» مشاهده کردند بلکه دغدغهی نسلهای آینده حالتی مسری داشتند. بیش از نیمی از اقداماتی که درمورد آنها توافق جمعی حاصل شد، پیشنهاد گروه نوههای خیالی بودند.

داستان بشر ممکن است پیش از آنکه واقعاً شروع شود، پایان یابد

دوراندیشی نشان میدهد که جوامع هنوز میتوانند دستاوردهای بیشتری داشته باشند. تنها پانصد سال پیش، غیرقابلتصور بود که روزی درآمد مردم هرچند نسل یک بار دو برابر شود، اغلب مردم آنقدر زندگی کنند که بزرگشدن نوههای خود را ببینند و کشورهای پیشرفتهی جهان جوامعی سکولار داشته باشند که رهبرانشان در انتخابات آزاد تعیین میشوند. کشورهایی که اکنون برای شهروندانشان بسیار پایدار به نظر میرسند، ممکن است بیش از چند قرن دوام نیاورند. هیچیک از شیوههای متنوع سازماندهی اجتماعی در طول تاریخ از ابتدا شکل کاملی نداشتهاند. تمرکز بر روزها، ماهها یا سالها، امکان تحول بنیادین در بلندمدت را از نظر دور نگاه میدارد.

این واقعیت که نوع بشر تنها دوران خردسالی خود را طی میکند، توجه ما را بیشازپیش بر این نکته متمرکز میکند که مرگ نابهنگام آن چقدر غمانگیز خواهد بود. هنوز زندگیهای بسیاری باید زیسته شوند اما در خردسالی، توجه ما بهسرعت از چیزی به چیز دیگر میپرد و ناآگاه از اینکه بعضی از کارهایمان ممکن است ما را در خطری جدی قرار دهد، به اینطرف و آنطرف تِلوتِلو میخوریم. تواناییهای ما هر روز افزایش مییابد اما خودآگاهی و خردمندیمان عقب میافتد. داستان ما ممکن است پیش از آنکه واقعاً شروع شود، پایان یابد.

پایان تاریخ را چگونه ممکن است رقم زنیم؟

برخلاف «پایان تاریخ» فوکویاما، دیگر ناظران مسائل بینالمللی بر معنای تحتاللفظیتر این عبارت بیشتر تمرکز کردهاند: این امکان بالقوه که بشر بهکلی نابود شود. چنین دیدگاههایی بهویژه در ابتدای جنگ سرد رواج داشت، اندکی بعد از آنکه دانشمندان اتمی جهشی بزرگ در تواناییِ ویرانگریِ بشر ایجاد کردند. همانگونه که وینستون چرچیل، دولتمرد انگلیسی، در سال ۱۹۴۶ بهشکلی گویا گفته: «عصر حجر ممکن است بر بالهای صیقلخوردهی علم بازگردد و آنچه اکنون منبع مواهب مادی بیاندازهای برای بشر است، ممکن است عاقبت باعث نابودی کامل آن شود.» چند سال بعد از آن، رئیسجمهور آمریکا، دوایت آیزنهاور، در نخستین سخنرانی دوران ریاستجمهوریاش این دغدغهها را تکرار کرد و از جمله هشدار داد: «ظاهراً علم آماده است که آخرین هدیهی خود را به ما بدهد، یعنی قدرت نابودی زندگی بشر بر روی این کرهی خاکی را.»

تاریخ نوع بشر آکنده از فجایع است، از همهگیری طاعون تا بردهداری و استعمار. اما بهجز چند حادثهی طبیعیِ بسیار نامحتمل، مانند فعالشدن آتشفشانی بسیار بزرگ یا برخورد شهابسنگها با زمین، هیچ سازوکار معقولی وجود نداشته است که بتواند تمام نوع بشر را نابود کند. در کتاب پرتگاه، فیلسوف آکسفوردی، توبی اُورد، تخمین میزند که حتی با پذیرش همهی پیشفرضهای بدبینانه، خطر انقراض طبیعی درمجموع به بشر دستکم حدود ۱۰۰هزار سال زمان خواهد داد.

نگرانیهای جدی دربارهی «فاجعهی نابودکننده» که اُورد آن را نابودیِ دائمیِ تواناییِ بالقوهی نوع بشر تعریف میکند، عمدتاً از نیمهی دوم قرن بیستم و همزمان با شتابگرفتن پیشرفت فناوری، به وجود آمد. لرد مارتین ریس، مدیر سابق انجمن سلطنتی، در سال ۲۰۰۳ نوشت که امکان بقای نوع بشر در این قرن «بیش از ۵۰درصد نیست». اُورد تخمین میزند که احتمال آنکه نوع بشر خود را نابود یا بهطور دائمی روند تمدن را مخدوش کند، در صد سال آینده یک از شش است. حق با هریک از این دو نفر باشد، محتملترین علت جوانمرگشدن هر آمریکاییای که امروز به دنیا میآید، وقوع فاجعهای در ابعاد ویرانیِ تمدن است.

تا همین اواخر، راههای اندکی وجود داشت که نوع بشر به کلی نابود شود

سلاحهای اتمی چند ویژگی اصلی دارند که ممکن است خصیصهی خطرات ناشی از فناوریهای آینده نیز باشد. وقتی این سلاحها در اواسط قرن بیستم به وجود آمدند، جهشی ناگهانی در توانمندیهای ویرانگر بشر پدید آوردند: بمب اتم هزار برابر قویتر از همهی مواد منفجرهی قبل از کشف اتم بود؛ بمبهای هیدروژنی هم هزار بار از بمب اتم قویترند. در مقایسه با سرعت افزایش قدرت ویرانگری سلاحها در عصر پیشااتمی، پیشرفت چند دهه معادل ۱۰هزار سال بود.

این پیشرفتها را مشکل میشد پیشبینی کرد: ارنست رادرفورد، فیزیکدان برجسته، ایدهی انرژی اتمی را حتی در سال ۱۹۳۳، «توهم» میخواند و آن را رد میکرد، یعنی یک سال پیش از آنکه لئو استیلارد، فیزیکدان مشهور دیگر، ایدهی ساختن یک رآکتور مبتنی بر شکافت هستهای را به ثبت رساند. وقتی بمبهای اتمی از راه رسیدند، ویرانی ناشی از آنها میتوانست نتیجهی تصمیمی عامدانه باشد، مثل زمانی که در سال ۱۹۵۸ در میانهی بحران تنگهی تایوان (Taiwan Strait crisis) ژنرالهای آمریکایی پیشنهاد دادند که حملهی اتمی پیشدستانهای به چین انجام شود؛ یا ممکن بود تصادفی باشد، مانند آنچه در تاریخچهی هراسانگیز شلیکهای اشتباه در سیستمهای اخطاردهندهی اولیه ثبت شده است. حتی بدتر از آن، اقداماتی که هدفشان دفاع در برابر حملات عامدانهی اتمی بود، اغلب به قیمت افزایش این خطر تمام میشد که آخرالزمانی اتمی بهشکل تصادفی رخ دهد. برای نمونه، سیستم هشدار هوایی ایالات متحده را در نظر بگیرید که بر ایدهی شلیک بر اساس هشدار مبتنی بود، یا به سیستم «دست مرگ» در اتحاد جماهیر شوروی فکر کنید که تضمین میکرد اگر مسکو هدف حملهی اتمی قرار گیرد، بهطور خودکار حملهی اتمی متقابل با تمام قوا آغاز شود. پایان جنگ سرد در این محاسبات کشنده تفاوت بنیادینی ایجاد نکرد و قدرتهای اتمی هنوز در کانون سیاستگذاریهای خود، توازن امنیتی و آمادگیِ حمله را حفظ کردهاند. فناوریهای آینده ممکن است حتی معاملههای خطرناکتری را میان امنیت و تواناییِ حمله در پی داشته باشد.

آخرالزمانی نزدیک؟

اما سلاحهای اتمی تنها خطری نیستند که با آن مواجهیم. بسیاری از فناوریهای آینده میتوانند ویرانگرتر از آنها باشند، آسانتر به دست گسترهی وسیعتری از کنشگران بیفتند، کاربردهای دوگانهی نگرانکنندهتری داشته باشند یا برای آغاز انقراض گونهی ما به گامهای اشتباه کمتری نیاز داشته باشند و بنابراین، کنترل آنها بسیار مشکلتر خواهد بود. گزارش اخیر شورای امنیت ملی آمریکا، هوش مصنوعیِ کنترلنشدنی، بیماریهای همهگیرِ مهندسیشده و سلاحهای مبتنی بر فناوری نانو را علاوه بر جنگ اتمی از جمله عوامل خطر نابودی نوع بشر قلمداد میکند: «خطراتی که میتواند به زندگی در مقیاسی جهانی آسیب بزند» و «تصور و درک مقیاس و گسترهی بالقوهی آنها، برای ما چالشانگیز است».

برای نمونه، همهگیریهای مهندسیشده را در نظر بگیرید. پیشرفت در فناوریِ زیستی بسیار سریع بوده و هزینههای اصلی آنها، مثلاً در مورد ساخت زنجیرههای ژنتیکی، بهسرعت کاهش پیدا کرده است. پیشرفتهای بیشتر مزایای بسیاری را نوید میدهند، مانند درمان ژنتیکیِ بیماریهایی که اکنون قابل درمان نیستند. اما کاربردهای دوگانهی این فناوری بهشدت نگران کنندهاند: برخی از روشهایی که در پژوهشهای پزشکی به کار میروند، در اصل، میتوانند برای شناخت یا ایجاد ارگانیسمهای بیماریزایی استفاده شوند که از هر نمونهی مشابه دیگری در طبیعت مسریتر و کشندهترند. این اتفاق ممکن است در یک برنامهی علمیِ باز اتفاق بیفتد (که در آن گاهی دانشمندان عوامل بیماریزا را تغییر میدهند تا راه مقابله با آنها را فرابگیرند) یا نتیجهی نیتهای شرورانهی تروریستها یا برنامههای سلاحهای زیستیِ دولتها باشد (چنین برنامههایی به تاریخ نپیوستهاند: گزارش یک وزارتخانه در ایالات متحده به این نتیجه رسید که کرهی شمالی و روسیه برنامههایی تهاجمی برای تولید سلاحهای زیستی دارند). پژوهشهایی که با انگیزهی خدمت به جوامع منتشر میشوند، میتوانند از سوی کنشگران بدکار مورد سوءاستفاده قرار گیرند، شاید به روشهایی که مؤلفان اولیهی این پژوهشها هرگز تصور نمیکردند.

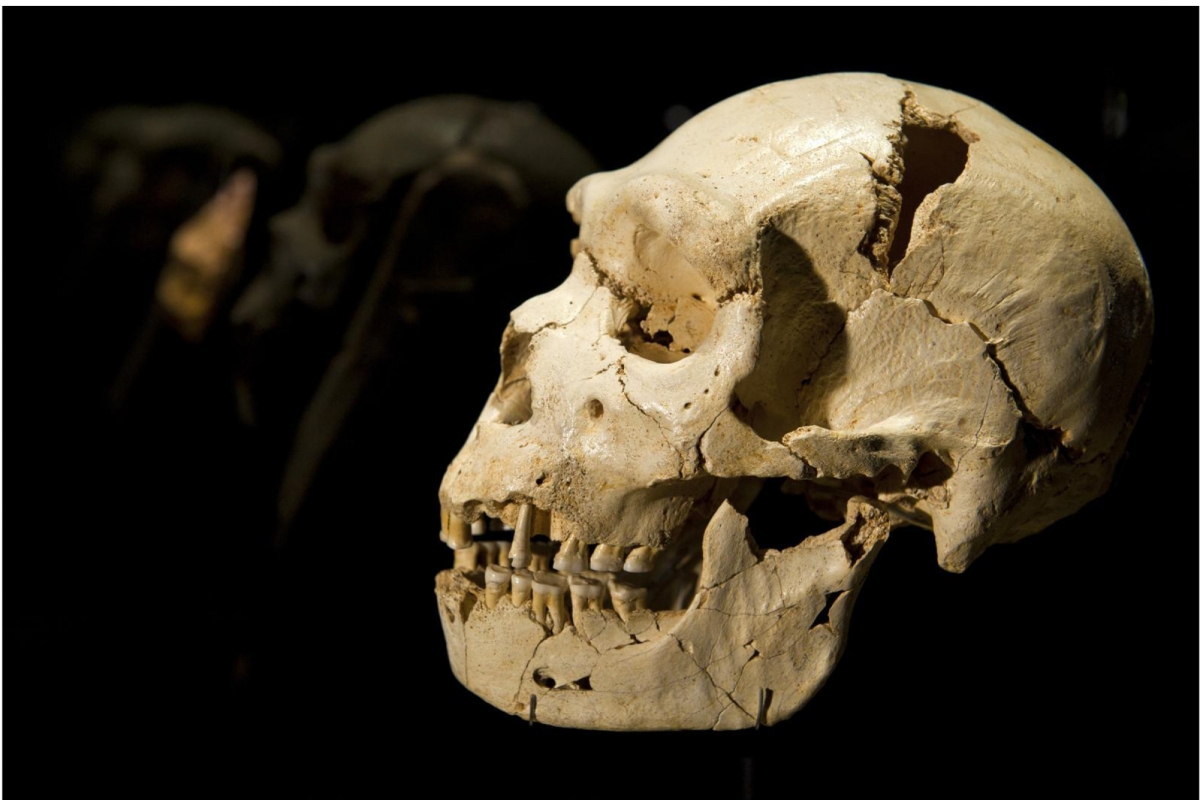

عکس: کاسهی سر و استخوان فک گونههای اولیهی انسانی در موزهی تکامل بشر در بورخس، اسپانیا، ژوئیهی ۲۰۱۰

برخلاف سلاحهای هستهای، باکتریها و ویروسها میتوانند خود را تکثیر کنند. همانطور که همهگیری کووید-۱۹ بهشکلی غمانگیز نشان داد، وقتی ارگانیسم بیماریزای جدید انسانی را بیمار کند، ممکن است دیگر راه نجاتی وجود نداشته باشد. و گرچه تنها نه کشور تاکنون سلاح اتمی دارند (و روسیه و ایالات متحده بیش از ۹۰درصد از کلاهکها را در اختیار دارند) اما هزاران آزمایشگاه زیستشناسی در دنیا وجود دارد. یک دوجین از این آزمایشگاهها (که در پنج قاره پراکندهاند) از مجوزهای لازم برای آزمایش روی خطرناکترین ارگانیسمهای بیماریزا در جهان برخوردارند.

بدتر از این، سوابق مشکلات ایمنی در پژوهشهای زیستشناختی حاکی از ناامنی شدیدتر نسبت به سلاحهای اتمی است. در سال ۲۰۰۷، بیماری پا و دهان که بهسرعت از طریق جمعیتهای دامی گسترش پیدا میکند و بهراحتی میتواند میلیونها دلار آسیب اقتصادی به بار آورد، نهتنها یک بار بلکه دو بار از یک آزمایشگاه بریتانیایی در فاصلهی چند هفته نشت کرد، بهرغم اینکه در این فاصله دولت برای حل مشکل مداخله کرده بود. و نشتهای آزمایشگاهی تاکنون به مرگ انسانها نیز انجامیدهاند، مانند زمانی که سیاهزخمِ جنگافزار شده، از کارخانهای مرتبط با برنامهی تسلیحات زیستیِ شوروی در سوردلوسک در سال ۱۹۷۹ به بیرون نشت کرد و دهها نفر را کشت. شاید از همهی اینها نگرانکنندهتر شواهدی ژنتیکی باشد که نشان میدهد سرآغاز همهگیریِ «آنفولانزای روسی» در سال ۱۹۷۷ احتمالاً آزمایشهایی انسانی است که روی زنجیرهی ژنتیکیِ آنفولانزای شایع در دههی ۱۹۵۰ انجام شده بود. تقریباً ۷۰۰هزار نفر بر اثر ابتلا به این بیماری درگذشتند.

درمجموع، تنها در آزمایشگاههای آمریکا تاکنون صدها بار بیماریهای عفونی نشت کردهاند، یعنی یک مورد در هر ۲۵۰ نفر / سال از کار آزمایشگاهی. از آنجا که دهها آزمایشگاه با درجهی امنیتی بالا در جهان وجود دارد و در هریک از آنها دهها و شاید حتی صدها دانشمند و کارمند فعالیت میکنند، این درصد احتمال وقوع خطا بهمعنای نشت بیماریهای عفونیِ متعدد در هر سال است. جوامع باید این احتمال را به میزان چشمگیری کاهش دهند. اگر این آزمایشگاهها سرگرم دستکاریِ ارگانیسمهای بیماریزایی باشند که میتواند به انقراض بشر بینجامد، پایان نابهنگام بشر، قطعی و تنها نیازمند گذر زمان خواهد بود.

حکمرانیِ در پایان جهان

بهرغم این سطح فزاینده از خطرات، هنوز اصلاً مشخص نیست که آیا نوع بشر گامهای لازم را برای حفاظت از خود خواهد برداشت یا نه. در واقع، موانع فراوانی در برابر کاهش کافیِ مخاطرات وجود دارد.

بنیادیترین موضوع در این رابطه را بهشکلی دردناک در کارزارهای مرتبط با دیپلماسیِ اقلیمی در سالهای اخیر دیدهایم. برخی کشورها بیش از بقیه از سوزاندن سوختهای فسیلی سود میبرند اما دیگر کشورها و نسلهای بعدی بیشترین هزینههای آن را خواهند پرداخت. به همین ترتیب، انجام پژوهشهای زیستشناختیِ پرخطر به امید ساختن داروهایی قابلثبت انجام میشود که میتواند اقتصاد و جایگاه بعضی کشورها را ارتقا دهد اما اگر ارگانیسمهای بیماریزا بهطور تصادفی در آن کشور نشت کند، شیوع آن محدود به داخل مرزهای میان کشورها نخواهد بود. به زبان اقتصاد، ایجاد خطر برای آینده برای اقتصادها زیانی بیرونی است، درحالیکه اقدامات برای کاهش خطر مانند ایجاد یک سیستم هشدارِ زودهنگام برای بیماریهای جدید، نوعی خیرِ عمومیِ جهانی است. (توجه کنید که چقدر برای کل دنیا سودمند بود اگر کووید-۱۹ مانند سارس در سالهای ۲۰۰۲ تا ۲۰۰۴ به تعداد کمی از کشورها محدود و سپس ریشهکن میشد.) این دقیقاً آنگونه خیری است که نه بازار آن را بهطور خودکار تأمین خواهد کرد و نه نظام بینالمللی زیرا کشورها انگیزههایی قوی دارند که از مزایای حاصل از زیان سایر کشورها بهطور مجانی سود ببرند.

بشر برای فرار از این فاجعهی ساختاری چند راه دارد. برای کاهش نگرانیهای مرتبط با شکست در مبارزه با خطرات امنیتی، کشورها میتوانند توافقنامههایی وضع کنند که بر اساس آن همگی از توسعهی فناوریهای فوقالعاده خطرناکی مانند سلاحهای زیستی خودداری کنند. راه دیگر، ایجاد اتحادی است میان کشورهای داوطلب تا بتوانند آنچه ویلیام نوردهاوس، اقتصاددان، آن را «انجمن کشورها» میخواند، تشکیل دهند. اعضای چنین انجمنی میتوانند در جهت تأمین خیر عمومیِ جهانی که ترویج آن هدف این نهاد است، با یکدیگر همکاری کنند. درعینحال، آنها میتوانند به تأمین مزایایی برای یکدیگر متعهد شوند (مثلاً کمک به پیشرفت اقتصادی یا صلح)، درحالیکه هزینههایی را (از طریق تمهیداتی مانند گمرک) بر کشورهای غیر عضو تحمیل و با این کار آنها را به عضویت در این انجمن تشویق کنند. برای نمونه، میتوان انجمنهایی برای تعیین معیارهای امنیتی درمورد سامانههای هوش مصنوعی یا ممنوعیت موقت پژوهشهای خطرناک زیستشناختی تأسیس کرد.

برای فرار از این فاجعهی ساختاری، راههایی وجود دارد

متأسفانه ظهور دوبارهی رقابت میان ابرقدرتها امکان موفقیت چنین همکاریهای جهانیای را در سایهای از ابهام فرو برده است. از آن بدتر، تنشهای ژئوپلیتیک میتواند کشورها را به پذیرش سطوح بالاتری از خطر برای جهان (و خودشان) وادار کند، بهویژه اگر چنین پذیرشی را قماری ببینند که در صورت برندهشدن در آن میتوانند منافع امنیتی خود را بهتر تأمین کنند (در هشت سالی که ایالات متحده بمبافکنهای خود را بهطور دائمی در آسمان نگه داشت، پنج هواپیما درحالیکه حامل بمبهای اتمی بودند، سقوط کردند). و حتی اگر برنامهی سلاحهای زیستیِ کشوری ارگانیسمهای بیماریزا با خطر انقراض بشر را آزمایش کند (شاید با این هدف بیپروا که عامل منعکنندهی نهایی را در دست داشته باشند)، حادثهی بعدی در یک آزمایشگاه میتواند همهگیریِ جهانیای بهمراتب بدتر از کووید-۱۹ را شیوع دهد.

در بدترین حالت، ابرقدرتها میتوانند در جدال خود برای تسلط جهانی به جنگ مستقیم روی آورند. برای کسانی که در غرب و بعد از جنگ جهانی دوم به دنیا آمدهاند، این تصور ممکن است دور از انتظار به نظر برسد. استیون پارکر، روانشناس، این ادعا را ترویج کرد که خشونت (از جمله خشونت میان کشورها) مدتهاست که محدود شده است. اما تحلیلهای بعدیِ بِر براومولر، دانشمند علوم سیاسی، و همکاران او نشان داد که موضوع به این سادگی نیست. پژوهشگران گفتهاند که شدت برخوردها از قانونی به نام «قانون قدرت» تبعیت میکند، به این معنا که بعد از وقفهای نسبتاً صلحآمیز، کاملاً ممکن است که دوباره جنگ بهشکلی حتی مرگبارترآغاز شود. محاسبات آرون کلاوست، دانشمند علوم رایانهای، نشان داده که «صلح بلندمدت» که پس از جنگ جهانی دوم به وجود آمده، باید یک قرن دیگر ادامه یابد تا بتوان آن را شاهدی پذیرفتنی مبنی بر کاهش واقعاً بلندمدتِ وقوع جنگ به شمار آورد. براومولر تأیید میکند که «بعید نیست که جنگی دیگر و مرگبارتر از دو جنگ جهانی گذشته در طول زندگی ما اتفاق بیفتد» و در بخش پایانیِ کتاب خود اشاره میکند که «برای مدتی میخواسته بنویسد: "ما همه خواهیم مرد" و سخن را در همانجا خاتمه دهد».

کاهش خطر جنگ جهانی سوم همزمان با دستیابی به نوآوریهایی بیسابقه در شیوهی حکمرانیِ بینالمللی، هدفی دشوار است. اما خوشمان بیاید یا نیاید، این چالشی است که با آن مواجهیم.

نوآوری برای بقا

یک واکنش به چالش سهمگین پیش رو، عقبنشینی است. به باور بعضی، اگر بهسختی میتوان ظهور فناوریهای جدید را بهشکلی امن به پیش برد، اصلاً چرا اختراع آنها را کنار نگذاریم؟ اعضای جنبش «مهار رشد» دقیقاً همین موضع را دارند و علیه رشد اقتصادی فریاد میزنند و پیشرفت فناوری را مهمترین عامل ازخودبیگانگی، ویرانیِ زیستمحیطی و همهنوع آسیبهای دیگر اعلام میکنند. در سال ۲۰۰۹، ۱۱هزار دانشمند از بیش از ۱۵۰ کشور نامهی سرگشادهای امضا کردند که خواهان «توقف رشد» جمعیت جهان «و در بهترین حالت، کاهش تدریجی آن» بود و میخواستند که کشورها «افزایش تولید خالص داخلی» را از اولویتهای خود کنار گذارند.

این واکنش با وجود جذابیت شهودیاش، غیرواقعبینانه و خطرناک است. غیرواقعبینانه است چون به وابستگیِ متقابل کشورها در نظام بینالمللی توجه نمیکند. حتی اگر کشورهای جهان گرد هم آیند و بهطور موقت نوآوری را متوقف کنند، دیر یا زود کسی دوباره توسعهی فناوریهای پیشرفته را آغاز خواهد کرد.

بشر نباید به سرنوشت ایکاروس دچار شود اما بااینحال باید پرواز کند

هرچه باشد، توقف در پیشرفت فناوری درهرحال مطلوب نیست. برای درک دلیل این موضوع، توجه کنید که فناوریهای جدید میتوانند هم خطرات را افزایش و هم کاهش دهند. وقتی فناوری جدیدی (مانند سلاحهای اتمی) خطراتی را ایجاد میکند، دولتها ممکن است برای کنترل آن خطر به فناوریهای تازهای نیاز داشته باشند. برای نمونه، تهدید سلاحهای اتمی برای بقای نوع بشر کاهش مییافت اگر در پی یک فاجعهی اتمی بالقوه، مردم میتوانستند بدون نور خورشید غذا تولید کنند یا اگر سیستمهای هشدارِ زودهنگام میتوانستند بهطور قابلاعتمادی میان موشکهای بالستیک قارهپیما و راکتهای کوچکِ علمی فرق بگذارند. اما اگر جوامع پیشرفت فناوری را بهکلی متوقف کنند، ممکن است که خطرات تازهی فناوریها به وجود آیند و قابل کنترل هم نباشند زیرا گامهای جبرانی برای دفاع در برابر این خطرات برداشته نشده است. برای نمونه، عوامل بسیار متنوعی ممکن است ارگانیسمهای بیماریزای خطرناک و بیسابقهای را در زمانی به وجود بیاورند که هنوز پیشرفت چندانی در تشخیص و نابودی بیماریهای جدید حاصل نشده است.

بهعبارتدیگر، وضع کنونی هماینک نیز پر از خطرات بالقوهی فاجعهآمیز است. و در فقدان اقدامات پیشگیرانه، تهدیدهای طبیعت نیز ممکن است نهایتاً به انقراض بشر بینجامند، همانطور که بسیاری از گونههای دیگر نیز چنین شدند: بشر برای اینکه بهطور کامل توان بالقوهی خود را برای بقا متحقق کند، باید کارهایی مانند منحرفکردن شهابسنگها و مبارزهی فوری با بیماریهای همهگیر را بیاموزد. بشر نباید به سرنوشت ایکاروس دچار شود اما بااینحال باید پرواز کند.

چالش این است که چگونه از ثمرات پیشرفت فناوری بهرهمند شویم و درعینحال بشر را از عوارض مخرب آن حفظ کنیم. برخی متخصصان به این موضوع با عنوان «پیشرفت تناسبیِ فناوریها» اشاره میکنند، یعنی این ایده که اگر مردم نمیتوانند جلوی تصادفها یا فناوریهای مخرب را بگیرند، میتوانند با آیندهنگری و برنامهریزیِ دقیق دستکم سعی کنند که ابتدا فناوریهای مفید و امنیتبخش را توسعه دهند.

ما هماینک نیز در میانهی بازیای هستیم که ریچارد دانزیگ، فرماندهی سابق نیروی دریایی آمریکا، آن را «رولت فناوری» میخواند. هنوز هیچ گلولهای شلیک نشده اما این امر خطرناکبودن این بازی را رد نمیکند. مقاطع بسیار بیشتری باقی مانده است که شاید در یکی از آنها ماشه کشیده شود: تصادف بد و شاید مرگبار اجتنابناپذیر است، مگر آنکه بشر بازی را تغییر دهد.

دِین ما به آینده

تا اینجا عوامل چندانی برای تغییر بازی وجود نداشته است. با توجه به سود و زیان احتمالی، تا این تاریخ تلاشهای جوامع برای حفظ آینده بهشدت اندک بوده است. برای نمونه، به معاهدهی سلاحهای زیستی توجه کنید که تولید، ذخیره و بهدستآوردن سلاحهای زیستی را محدود میکند. دانیل گرستاین، متخصص امنیت ملی، این کنوانسیون را «مهمترین معاهدهی کنترل تسلیحات در قرن بیستویکم» توصیف میکند اما این کنوانسیون فاقد سازوکارهای نظارتی است و بودجهاش از بودجهی مِتگالا (Met Gala) بسیار کمتر است. حتی به همین میزان از بیکفایتی اکتفا نشده چون این کنوانسیون برای تأمین بودجهی اندک خود با مشکل روبهروست و گزارشی از سال ۲۰۱۸ که رئیس کنوانسیون آن را نوشته، از «وضعیت شکننده و رو به وخامت کنوانسیون منع سلاحهای زیستی از نظر اقتصادی... بهدلیل نپرداختن سهم حمایتیِ تعیینشده از سوی بعضی از کشورهای عضو در بلندمدت» شکایت میکند.

مدیریت خطرات غیرزیستی نیز چندان اطمینانبخش نیست. پژوهشهایی که خواهان جلوگیری از خروج سامانههای هوش مصنوعی از کنترل هستند، تنها بخش بسیار اندکی از پژوهشهای مرتبط با هوش مصنوعی را تشکیل میدهند. و ارتشها در حال ایجاد سلاحهای خودکارِ مرگبار در میدان جنگ هستند، درحالیکه کوشش برای محدود نگاه داشتن این سامانههای تسلیحاتی سالهاست که در سازمان ملل معوق مانده است. وضعیت داخلی آمریکا هم بهتر به نظر نمیرسد، کمتر از ۱درصد از بودجهی دفاعی آمریکا به دفاع در برابر سلاحهای زیستی اختصاص دارد و بخش عمدهی آن هم صرف مبارزه با تهدیدهایی مانند سیاهزخم میشود. حتی بعد از آنکه کووید-۱۹ یک نفر از هر پانصد نفر در جهان را کشته و تنها به ایالات متحده ۱۶تریلیون دلار آسیب اقتصادی زده، کنگرهی آمریکا حتی نمیتواند بودجهای ۱۵میلیارد دلاری برای شتاببخشیدن به آمادگی برای همهگیریها اختصاص دهد.

غفلت از این نوع کوششها برای کاهش خطرات چنان شدید است که فرصت برای تغییر مثبت بهوفور در دسترس است. یکی از داستانهای موفقِ کاهش خطر نابودی، برنامهی سیفگاردِ ناسا است. با هزینهای کمتر از ۵میلیون دلار در سال، از زمان شروع این برنامه در سال ۱۹۹۸ تا سال ۲۰۱۰، دانشمندان بیش از ۹۰درصد از شهابسنگهایی را که ممکن بود بشر را نابود کنند، تحتنظر گرفتند. با این کار دقت پیشبینیهایشان افزایش و احتمال برخورد یکی از آنها با زمین ده برابر کاهش یافت. در نظر داشته باشید که در طول همهگیری کووید-۱۹ دولت آمریکا ۱۸میلیارد دلار برای عملیات «وارپ اسپید» هزینه کرد تا تولید واکسن را سرعت دهد. درنتیجهی این برنامه واکسنهای امن و مؤثری تولید شد و ایالات متحده و دیگر کشورها توانستند آنها را با قیمتی خریداری کنند که معادل تنها بخش کوچکی از مزایای اجتماعی این واکسنها بود؛ مزایایی که دههاتریلیون دلار ارزیابی شدهاند. رابرت بارو، اقتصاددان، تخمین زده است که بین سپتامبر ۲۰۲۱ و فوریهی ۲۰۲۲ درنتیجهی استفاده از این واکسنها، هزینهی نجات جانِ هر آمریکایی بین ۵۵هزار و ۲۰۰هزار دلار بوده است، یعنی بیش از بیست برابر آستانهی هزینهی مؤثری که معمولاً سیاستگذاریها برای نجات جان بیماران در نظر میگیرند.

عکس: تظاهرات تغییرات اقلیمی در لندن، سپتامبر ۲۰۱۹

اگر بهترین و هوشمندترین افراد موجود قدم پیش گذارند و دولتها یا بخش خصوصی منابع مالی لازم را تأمین کنند، میتوانیم به موفقیتهای درخشانتری نیز دست یابیم. برای مثال، بررسیِ زنجیرههای ژنتیکیِ موجود در فاضلاب در سطح گسترده، هرچند هنوز با موانع تکنیکیِ جدی روبهروست اما میتواند بالقوه به تشخیص بیماریهای جدید در مرحلهای بینجامد که هنوز محدود و ریشهکنکردن آنها امکانپذیر است. مرکز پژوهش دربارهی اسیدنوکلئیکها در «مؤسسهی فناوری ماساچوست» بر دنبالکردن این چشمانداز تمرکز کرده است. بخشهای دولتی و خصوصی باید امکانات حفاظت شخصیِ بهتری تولید کنند و تحقیقات بیشتری دربارهی فناوریهای استریلیزهکردن مانند Far UVC انجام دهند؛ فرایندی مبتنی بر تابش یونیزهکننده که اگر موفقیتآمیز باشد، میتواند حفاظ دفاعیِ تقریباً فراگیری در مقابل ارگانیسمهای بیماریزا فراهم کند و در هر ساختمانی نصب شود. درمورد هوش مصنوعی، تحقیقاتی که با هدف امنکردن و قابلاعتمادکردن سامانهها انجام میشود، باید دهها برابر افزایش یابد. وجه اشتراک چنین اقداماتی، تأکید بر راهبردهای دفاعی است که بهخودیخود باعث ایجاد یا افزایش خطرات دیگری نمیشوند.

پیشرفت در حیطههای دیگری نیز امکانپذیر است. جمعآوری اطلاعات و تحلیل آن با هدف زیرنظرداشتن عوامل شناختهشدهی مخاطراتِ گسترده ضروری خواهد بود. و گرچه دستیابی به اطمینان کامل ناممکن است (همانطور که کارل ساگان، فضانورد، یک بار گفته بود، «نظریههایی که به پایان جهان اشاره میکنند، قابل راستیآزمایی از طریق آزمایش نیستند، یا دستکم بیش از یک بار نمیتوان آنها را آزمایش کرد») نظارت و پیشبینی آینده میتواند به شناسایی دغدغههای تازه کمک کند. در این زمینه، آخرین گزارش گلوبال ترندز [روندهای جهانی] از شورای امنیت ملی آمریکا دلگرمکننده بود زیرا شامل بحثی دربارهی مفهوم مخاطرات برای موجودیت بشر و خواهان «توسعهی راهبردهایی برای پایداری به منظور حفظ بقا» بود.

دولتها، مؤسسات و شرکتهای بیشتری باید چنین ایدههایی را جدی بگیرند. اصلاحات در شیوهی نظارتی مهم خواهند بود. کَس سانستاین، مدیر سابق یکی از دفترهای ساماندهی در کاخ سفید، در کتاب جانبهدربُردن از فاجعه نشان میدهد که چگونه رویکرد کنونیِ دولت به تحلیل سود و زیان نمیتواند بهاندازهی کافی خطرات فجایع بالقوه را در نظر بگیرد. سانستاین از چیزی که «اصل بیش-کمینه» میخواند دفاع میکند: در مواجهه با خطراتی که بهاندازهی کافی جدی هستند (و انقراض بشر مطمئناً یکی از آنهاست) دولتها باید بر جلوگیری از بدترین وضعیتهای بالقوه تمرکز کنند. در شرایط فعلی، کاخ سفید در حال مدرنکردن چارچوب خود برای بازبینیِ اقدامات نظارتی است. باید از این فرصت استفاده شود و رویکردی مبتنی بر آمادگی برای خطرات کماحتمال اما پرآسیب در قرن بیستویکم اتخاذ شود، خواه با استفاده از اصل بیش-کمینهی سانستاین و خواه چیزی شبیه آنکه خطر فاجعههای جهانی را جدی میگیرد.

ما یکی از نخستین نسلهای تاریخ بشر هستیم

فوکویاما «قرنها ملالت را در پایان تاریخ» پیشبینی کرده بود. هیچ پیشبینیای اینقدر از واقعیت فاصله ندارد. فناوریهای قدرتمند و ویرانگر چالشی بیسابقه برای نظامهای سیاسی کنونی به وجود خواهند آورد. هوش مصنوعی میتواند توازن قدرتی را که میان افراد و دولتها برقرار است بر هم زند: نیروی کاریِ کاملاً اتوماتیک برای دولت دلیلی برای خوشرفتاری با شهروندان باقی نمیگذارد؛ دیکتاتوریِ بهرهمند از ارتش و پلیس متکی بر هوش مصنوعی، میتواند امکان انقلاب یا کودتا را از میان ببرد. حکومت میتواند به بهانهی جلوگیری از جنگ جهانی سوم دولت را بسط دهد و آزادیهای فردیای مثل آزادی بیان را به نام حفظ امنیت ملی مخدوش کند. امکان دسترسیِ آسان به سلاحهای زیستی میتواند بهانهای برای نظارت دائمی و همگانی باشد.

با توجه به آیندهی بشر، باید در مقابل این نوع فشارها مقاومت کنیم. باید مبارزه کنیم تا اطمینان یابیم که هم آیندهای داریم و هم این آینده ارزش زیستن را دارد. حرکت فرهنگ بهسوی لیبرالیسم در سه قرن اخیر به پیشرفت اخلاقی شتاب بخشیده و به توسعهی دموکراسی، ممنوعیت بردهداری و گسترش حقوق زنان و رنگینپوستان انجامیده است. این شتاب نباید اکنون متوقف شود. برعکس، باید گامهای بلندتری بهسوی ترویج تنوع و آزمونهای اخلاقی و سیاسی برداریم. با نگاهی به هزارهی گذشته، انسانهای مدرن شیوههای بردهداری، شکنجه برای تفریح و مردسالاریِ افراطی در میان رومیها را بربریت میدانند. شاید نسلهای آینده هم بسیاری از شیوههای کنونیِ زندگی را چندان بهتر تلقی نکنند.

پس باید بر این طناب گام برداریم. باید مطمئن شویم که همکاریهای جهانی خطرات فاجعههای جهانی را تقریباً به صفر میرسانند و به حفظ آزادی و تنوع فکر و ساختارهایی اجتماعی میانجامد که به ما امکان ساختن آیندهای مطلوب را میدهد و نوههای نوههایمان را سپاسگزار ما خواهد کرد. تفکر دربارهی تغییرات گستردهی سیاسی دلهرهآور است، اما نوآوریهای گذشته در شیوهی حکمرانی مانند نظام سازمان ملل و اتحادیهی اروپا امیدبخشاند.

ما عادت نداریم که خود را یکی از نخستین نسلهای تاریخ نوع بشر تلقی کنیم؛ معمولاً تمرکز بیشتر ما بر میراثی است که از گذشته به دستمان رسیده، نه میراثی که ما برای آینده به ارمغان میگذاریم. این اشتباه است. برای آنکه بتوانیم کار لازم را به انجام رسانیم، باید دربارهی جایگاه خود در تمامیت تاریخ بشر تأمل کنیم. امروز ما در حال قمارهایی بیپروا هستیم، نهفقط بر سر زندگی خودمان و کودکانمان بلکه بر سر موجودیت تمام نسلهایی که هنوز به دنیا نیامدهاند. بیایید آخرین نسلی باشیم که دست به چنین قمارهایی میزند.

برگردان: پویا موحد

ویلیام مکاسکیل استادیار فلسفه در دانشگاه آکسفورد و یکی از بنیانگذاران جنبش نوعدوستیِ مؤثر است. آنچه خواندید برگردان این نوشته با عنوان اصلیِ زیر است:

William MacAskill, ‘The Beginning of History’, Foreign Affairs, September/October 2022.